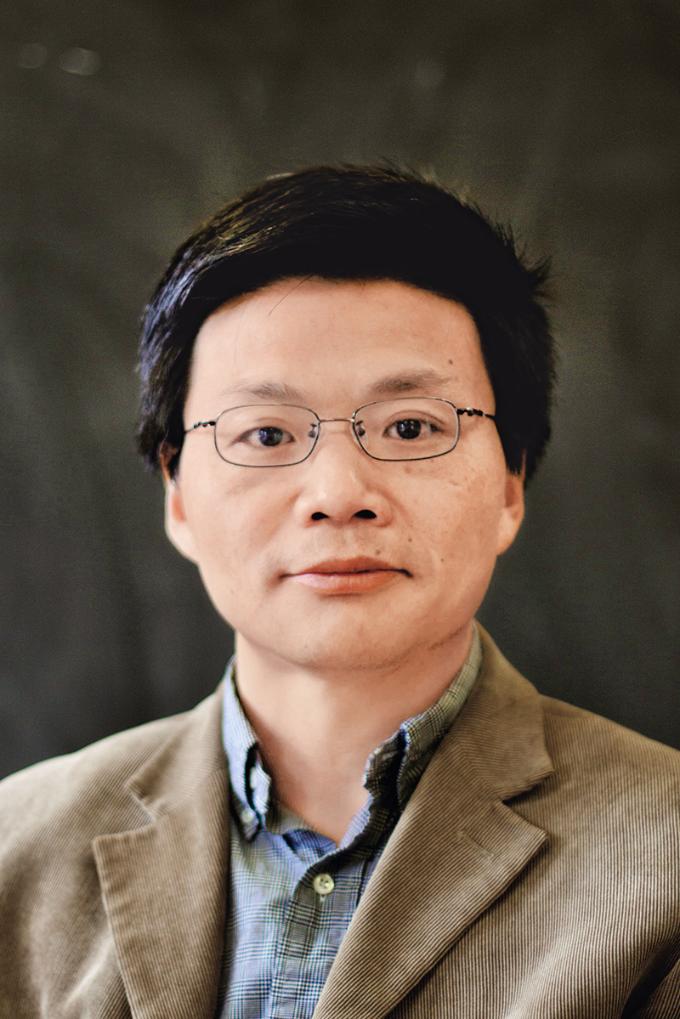

中国科学院院士鄂维南

从计算量和参数规模的角度来说,GPT存在巨大浪费。我们可以通过新的框架和计算方法来避免这种浪费

MyScale拓展了结构化查询语言,在同一个系统中支持海量结构化、向量、文本、JSON数据交换格式、空间、时序等各类异构数据的高效存储和联合查询,数据密度、插入速度、查询效率优于国内外其他系统

“忆立方”模型通过将知识分层处理,并引入内置数据库,来提高知识写入和读取的效率

文 |《瞭望》新闻周刊记者 扈永顺

最近十几年,以深度学习为代表的AI技术取得了巨大进展。大语言模型的成功,仿佛使人类站在了智能化时代的起点。但以GPT为代表的大模型技术路线并不适合我国国情。

什么才是适合我国国情的AI发展路径?如何才能保证我国AI长期稳定地发展?近日,中国科学院院士、北京大学国际机器学习研究中心主任鄂维南接受《瞭望》新闻周刊记者专访时表示,单纯堆砌大模型并非长久之计,我们应在以下两方面尽快布局:一是建立起一个完整的AI底层创新体系和创新团队,在模型架构、AI系统、数据处理工具、高效训练芯片等方向谋求新突破。二是探索AI的基本原理,尽管我们与掌握AI的基本原理还有很大差距,但是我们已经具备了探索这些基本原理的条件。而长期稳定发展的技术路线,必然会在这个探索过程中产生出来。

多年来,鄂维南带领团队积极探索适合中国国情的AI发展路径,尤其是在中国AI for Science的发展中起到了引领作用。

在网龙网络公司的中国福建VR体验中心,两名参观者在体验VR“智慧教室”(2024年7月18日摄) 魏培全摄/本刊

堆砌大模型之路不适合我国

《瞭望》:目前世界上主流的AI发展技术框架和思维模式是什么?

鄂维南:自2012年起,AI领域取得了显著的成就:2016年,基于深度强化学习的AI方法,DeepMind的AlphaGo在围棋比赛中战胜了世界冠军李世石,这是AI首次在围棋这一复杂游戏中击败人类顶尖选手。2023年,OpenAI发布了ChatGPT,这是一个强大的语言模型,它在自然语言理解和生成方面达到了前所未有的水平。今年,DeepMind推出了AlphaGeometry,这是一个能够在数学竞赛中表现出色的AI系统,展示了在解决复杂几何问题方面取得的突破。今年另一个值得关注的AI进展是Sora,它能够通过简单的文本提示生成逼真的视频,这标志着物理世界与虚拟世界之间的桥梁已经开始建立。此外,在科学领域,AI方法解决了蛋白结构这样一个生命科学中的基础问题,这是许多人未曾预料到的成就。

AI取得进步的一个重要原因就是深度神经网络的广泛应用。尽管深度学习受到热捧之前人们就已经在处理和分析大数据,但是真正让大数据充分发挥作用的方法是深度学习,其标志性事件是辛顿团队于2012年赢得ImageNet图像识别比赛冠军。辛顿等人设计并训练了一个神经网络,取名AlexNet。AlexNet有5层卷积网络、3层全连接网络,6000多万个参数。需要强调的是,辛顿等人在训练AlexNet的时候用的主要算法,如随机梯度下降、反向传播等都是已知的。辛顿团队的工作就是充分训练了这样一个多层神经网络。

辛顿等人的工作不仅改变了图像识别,而且改变了整个AI领域,因为基于神经网络的深度学习方法是一个通用方法。神经网络其实就是一类函数,它与多项式这类函数的不同之处在于它似乎是逼近多变量函数的有效工具。也就是说,它能够有效地帮助我们克服维数灾难和组合爆炸引起的困难,这是过去的AI方法难以做到的。因此神经网络也可以被用来解决科学领域碰到的多个自由度的问题,如蛋白结构问题、分子动力学势能函数问题等,由此催生出了一个崭新的科研范式:AI for Science。正因为深度学习在多变量函数逼近这样一个非常基础性的问题上带来了巨大突破,所以它在各种各样的问题上都给我们带来了新的可能。

大模型技术是一个新的突破。之前的深度学习技术考虑的是单个任务和单个数据集,大模型考虑的是所有任务和所有数据。以OpenAI的GPT为代表的大模型技术在文本任务和文本数据上展示了令人惊奇的成功。但总体来说,大模型技术还远没有成熟。

《瞭望》:为什么说这一主流的AI发展模式不适合我国?

鄂维南:从长远的角度来看,目前以GPT为代表的技术路径并不适合我国国情。

首先,我国的算力与美国的相比有相当大的差距。目前国内大模型第一梯队的算力资源基本上是万卡规模,比如拥有1万张英伟达A100或类似级别的GPU卡。然而美国的第一梯队能达到10万卡甚至更大规模,10万张卡的价值大约是200亿到300亿元人民币,这对许多团队来说是一个巨大的成本负担,许多开发基座模型的国内团队可能不得不停下追赶的脚步。

其次,从计算量和参数规模的角度来说,GPT存在巨大浪费。我们可以通过新的框架和计算方法来避免这种浪费。

最后,对图像等问题,GPT不一定是最佳技术路径,我们还需要寻求更加有效的技术方案。

工作人员在2024世界人工智能大会上展示手势控制机器人操作流程(2024年7月4日摄) 黄晓勇摄/本刊

建立完整的AI底层创新体系

《瞭望》:发展新一代AI,需要解决哪些问题?

鄂维南:要寻找替代路线,并保证我国AI得到持续、稳定的发展,就必须研究AI的底层逻辑,探索其基本原理,解决算力、数据、算法中的一些核心问题。另外,我们还需要探索数据以外的其他思路,包括逻辑推理、几何表示和物理规律的应用。

从算力角度看,我国已经建设了一些算力中心,比如万卡规模的机房。我们还需要持续投入,尽管需要寻求新的人工智能技术路径,但是在算力上的投入不能放松。未来我们可能需要考虑如何把分布在全国各地的算力资源有效地综合利用起来,以支撑基座模型的训练。要做到这一点,还需要从模型的层面、算法的层面做一些改变,寻找更加适合于分布式算力和远程通信的模型框架。

从数据角度看,我们需要一套高效率、标准化的数据处理工具。处理好数据是提升模型能力的主要手段。现在我们缺乏高效率的数据处理工具。除数据清洗和标注工具以外,还需要对数据做不同维度的画像的工具,评估数据质量、数据难度的工具等。

从算法和模型的角度来看,我们要给模型瘦身。目前的主流技术框架是把知识和推理能力都放在大模型里面。其实一些具体知识没必要放在模型里面。我们可以把它们存到一个知识库里面,让大模型随时调用。这样做就会大大降低模型规模。对不常用的知识,业界流行的外挂数据库就可以实现这一技术方案。对经常用的知识,我们需要更加高效的方法,这就是我们推出的“忆立方”模型要解决的问题。

我们还需要提高学习效率。目前大模型是纯粹通过刷题的方式来学习。例如为了做加减乘除运算,GPT即便是学了1万道题目,它也并没有真正学到加减乘除的规则。这样的算法不够有效,是在拼蛮力。

要解决这个问题,我们需要把规则和大模型的学习能力结合在一起。一个例子是DeepMind推出的AlphaGeometry,它求解国际奥林匹克数学竞赛中平面几何题目的能力接近了人类最高水平。它的主要做法是把逻辑推理方法和经验方法相结合:定理库和树搜索提供具体证明,而机器学习模型提供思路,比如如何加辅助线。简单来说,定理库里面就是很多平面几何的定理。一般平面几何最难的地方是如何加辅助线。这要靠经验,靠积累,这是大模型擅长的。下一步它就到定理库里面去找哪个定理可以用,用了以后能够把问题简化。这种方法不仅仅是对平面几何,在更广泛的场景都可以用。

《瞭望》:你带领团队在建立AI底层创新体系方面,已经做了哪些工作?

鄂维南:我们希望能够全方位探索AI基本原理并且在此基础上寻找下一代AI系统的技术路线。目前我们的努力主要集中在数据和模型两个方面。

在数据处理方面,我们团队研发了国际上第一个专门为大规模结构化+非结构化数据处理打造的AI数据库MyScale(此前称为MQDB),这也是目前国内综合性能最好、功能最强的AI数据库。

MyScale拓展了结构化查询语言,在同一个系统中支持海量结构化、向量、文本、JSON数据交换格式、空间、时序等各类异构数据的高效存储和联合查询,数据密度、插入速度、查询效率优于国内外其他系统。

比如,MyScale能够实现海量非结构化数据清洗,减少数据收集量、数据标注,提高效率,降低成本。假设我们要训练一个自动驾驶模型,我们就要处理各种不同的复杂场景。因此我们需要高效率、高精度地抽取相应场景的数据。我们可以在MyScale数据库中直接搜索“行人过马路”或“人行道上的行人或自行车”等场景来获取相应的数据,方便快捷。近期我们已将MyScale进行了开源,大部分功能已经在开源版本中推出,完全可以满足用户数据量不太大时候的需求,欢迎大家去使用。

在模型算法方面,我们团队打造了“忆立方”模型,它通过将知识分层处理,并引入内置数据库,来提高知识写入和读取的效率。根据一个知识的使用频率,来决定它的处理方式。使用频率最高的知识,我们把它放在大模型中,最低的放在外挂数据库中,常用的专业知识则放在内置数据库中。这样不但可以大大降低对模型规模的要求,同时也提高了知识的使用效率。

加快创新人才、创新生态培育

《瞭望》:建立完整的AI底层创新体系,还需要怎么做?

鄂维南:建立完整的AI底层创新体系,需要探索AI发展的底层逻辑和基本原理,这是AI长期发展的基础。没有对基本原理的理解,我们无法保证AI的持续进步,无法知道下一步该如何走。从AI发展的历史上看,它经历了几次大起大落,以及不断的小起小落。这种情况的出现,实际上也是因为我们对基本原理和底层逻辑的理解不够深入。

探索AI的基本原理是一个非常困难的任务,这一探索需要多方面人才、多方面资源的紧密合作和结合。

在人才培养方面,目前我们的主要精力都集中在离AI应用最近的人才身上,如机器学习、计算机视觉、自然语言处理等。但AI的长期稳定发展需要多方面、多层次的人才。建议从整个计算产业的角度全面布局AI发展蓝图,创新人才培养方式,培养综合性、前瞻性人才,建设高质量、多层次人才梯队。

现在很多高校都成立了AI学院,这既是好事,但也可能成为一件坏事。应该认识到,AI是一个非常特殊的学科,它不只是一个典型的专业,还是一个需要从全校层面进行规划和布局的核心领域。仅就人才培养来说,对于AI方面的专业人才,我们要同时注重基本原理的思维能力和工程能力;对非AI专业的人才,我们必须切实加强AI通识教育。

另外,建议注重实现人才资源和算力资源的有效对接。高校不缺人才但缺算力资源,大企业不缺算力但在人才资源方面处于劣势。我们需要将有限的人才资源和算力资源有效地对接起来。

从创新生态来看,加快建立鼓励原始创新的生态环境及文化,提倡做与众不同的事情,提倡“别人做了,我就不再去凑热闹”的科研心态。市场应给创新足够的生存空间,政府部门应更加重视资源分配的合理性。作为创新群体,我们必须具备高度的社会责任感、冒险精神和实干精神,下决心真正从源头上解决科技创新中面临的困难,开创崭新的局面。